近日,计算机视觉顶会CVPR 2024公布录用名单,视觉与媒体智能团队共有6篇论文录用。团队由马利庄教授领导,主要成员包括王长波教授、谢源教授、何高奇教授等。团队在预训练大模型、跨模态学习、训练加速、自动驾驶等领域取得突破。视觉与媒体智能团队近年来在TPAMI、TOG、TIP、TVCG等顶刊以及CVPR、ICLR、ICCV、AAAI等顶会都稳定有工作发表。

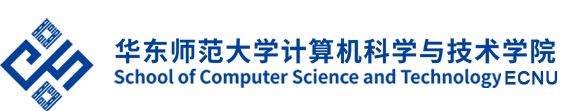

1、论文标题:PromptAD: Learning Prompts with Only Normal Samples for Few-Shot Anomaly Detection

作者及对应单位:

李晓凡(华东师范大学),张志忠(华东师范大学),谭鑫(华东师范大学),陈成伟(长海医院),曲延云(厦门大学),谢源(华东师范大学),马利庄(华东师范大学)

论文简介:

视觉语言模型在异常检测中需要手工设计大量提示,为了适应自动化场景,我们提出了适用于异常检测的PromptAD。首先,提出的语义拼接将可学习提示与反义提示拼接来生成多样的负样本参与训练,使模型仅用正常样本仍能学习到有效提示。其次,提出的显示异常边界保证正常提示与异常提示之间的距离。

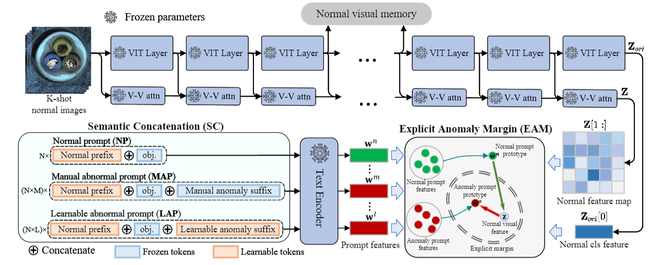

2、论文标题:Multi-modal In-Context Learning Makes an Ego-evolving Scene Text Recognizer

作者及对应单位:

赵震(华东师范大学),唐景群(字节跳动),张志忠(华东师范大学),谭鑫(华东师范大学),黄灿(字节跳动),谢源(华东师范大学)

论文简介:

真实世界的场景文本识别(STR)在处理域变化、字体多样性、形状变形等时经常遇到挑战。一个简单的解决方案是根据特定场景进行模型微调,但这是计算密集型的,并且需要针对各种场景的多个模型副本。为此我们提出一个用上下文丰富的场景文本序列训练的STR模型,使得常规大小的模型足以在STR中实现有效的上下文学习能力,从而无需微调即可实现域的自适应。

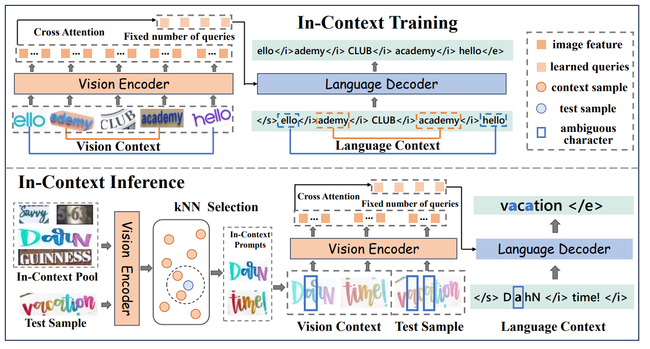

3、论文标题:COTR: Compact Occupancy TRansformer for Vision-based 3D Occupancy Prediction

作者及对应单位:

马启航(华东师范大学),谭鑫(华东师范大学),曲延云(厦门大学),马利庄(上海交通大学),张志忠(华东师范大学),谢源(华东师范大学)

论文简介:

3D空间占据感知由于其超强几何感知能力和通用物体识别能力受到了自动驾驶社区的广泛关注。为了避免2D BEV表征和TPV表征的几何削弱以及3D稀疏原始表征的高额开销,提出几何感知的编码器得到紧凑3D表征,同时使用语义感知的分组解码器缓解长尾问题。实验证明,方法在多个先进基线和数据集上均有明显提升。

4、论文标题:Building a Strong Pre-Training Baseline for Universal 3D Large-Scale Perception

作者及对应单位:

陈豪明(华东师范大学),张志忠(华东师范大学),曲延云(厦门大学),张睿欣(腾讯优图), 谭鑫(华东师范大学),谢源(华东师范大学)

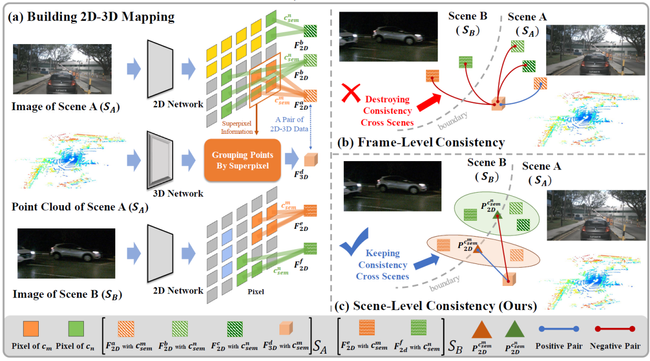

论文简介:

为了建立适用于大规模场景感知的预训练框架。我们提出了CSC方法,以场景级语义一致性为核心,为不同场景中相似语义片段架起连接的桥梁。由CSC得到的预训练3D网络,经过少量任务标签微调后,在语义分割、目标检测、全景分割三种下游感知任务上均优于现有方法。

5、论文标题:CLIP-Driven Open-Vocabulary 3D Scene Graph Generation via Cross-Modality Contrastive Learning

作者:陈梁港旭,王雪娇,卢嘉乐,林绍辉,王长波,何高奇

单位:华东师范大学计算机科学与技术学院

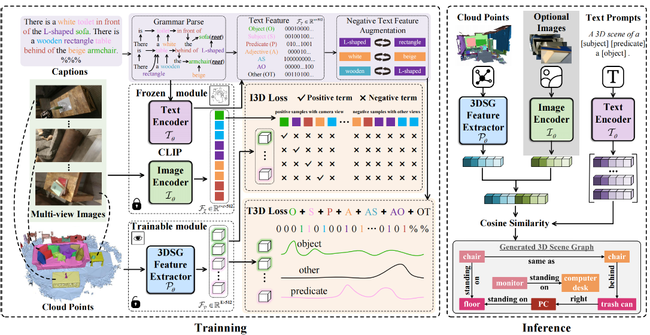

论文简介:针对现有的3D场景图生成方法依赖注释和闭集训练的问题,本文提出了一种新颖的跨模态对比学习方法。首先,为了将文本与场景图对齐,将文本解析为与场景图注释一致的单词级别。为了增强对齐过程中的稳健性,将形容词作为负样本交换给不同的对象。然后,为了将图像与场景图对齐,将相机视图视为正样本,将其他视图视为负样本。最后,通过计算提示和场景图特征之间的余弦相似度,实现了对未见过的对象类和谓语类的识别。实验表明我们的模型在现实世界中具有卓越的开放词汇能力和适用性。

6、论文标题:A General and Efficient Training for Transformer via Token Expansion

作者及对应单位:

黄文轩(华东师范大学)、沈云航(腾讯优图)、谢娇(华东师范大学)、张宝昌(北京航空航天大学)、何高奇(华东师范大学)、李柯(腾讯优图)、孙星(腾讯优图)、林绍辉(华东师范大学)

论文简介:

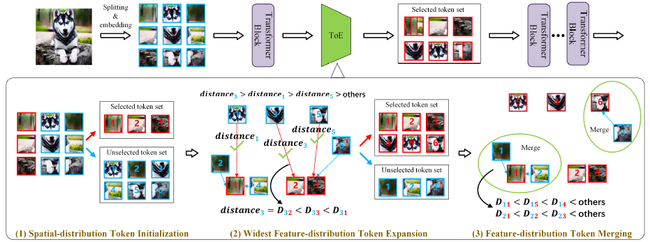

本文提出一种token增长的训练加速方法,在不修改原Transformer超参数、架构和策略下完成Transformer网络的训练加速。该方法可无缝适配不同ViT模型、训练模式及其它加速训练方法。特别地,引入了“初始化-增长-融合”流程保持Transformer模型的中间特征分布的完整性,避免训练过程信息丢失。实验验证了提出方法的通用性和有效性。

Code链接:https://github.com/Osilly/TokenExpansion

中山北路3663号理科大楼 200062

沪ICP备05003394

Copyright 2019计算机科学与技术学院